挑战英伟达! AMD推出AI芯片MI300X 亚马逊与Meta将“尝鲜”

智通财经APP获悉,CPU与GPU双产业巨头、英伟达竞争对手之一AMD(AMD.US)于美东时间周二展示了其即将推出的人工智能处理器系列产品,旨在帮助数据中心处理大量人工智能数据流量,并挑战英伟达(NVDA.US)在这个新兴市场的强势主导地位。

AMD周二在旧金山的新品发布会中表示,该公司推出的Instinct MI300系列将包括一个加速器,可以加快ChatGPT和其他聊天机器人等生成式人工智能产品背后的数据处理速度。这款名为MI300X的产品是最早于今年1月在国际消费电子展(CES)上公布的产品系列阵容的其中一部分内容。

AMD全新推出的GPU专用MI300,即MI300X,是针对大语言模型(LLM)的优化版,拥有192GB的HBM3内存、5.2TB/秒的带宽和 896GB/秒的Infinity Fabric 带宽。AMD将1530亿个晶体管集成在共12个5纳米的小芯片中。AMD表示,MI300X提供的HBM密度最高是英伟达AI芯片H100的2.4倍,其HBM带宽最高是H100的1.6倍。这意味着,AMD的芯片可以运行比英伟达芯片更大的模型。AMD未披露具体的价格。

苏姿丰介绍,MI300X可以支持400亿个参数的Hugging Face AI 模型运行,并演示了让这个LLM写一首关于旧金山的诗。这是全球首次在单个GPU上运行这么大的模型,单个MI300X可以运行一个参数多达800亿的模型。AMD首席执行官苏姿丰表示,随着模型规模越来越大,就需要多个GPU来运行最新的大型语言模型,而随着AMD芯片内存的增加,开发人员将不再需要那么多数量的GPU,意味着可以节约成本。

与芯片行业的许多公司一样,AMD正在竞相满足其客户对人工智能计算日益增长的需求。依赖于大语言模型(LLM)的流行服务——即处理大量数据以回答使用者查询的问题和生成图像的算法,正在将数据中心算力推向极限。

到目前为止,英伟达在提供处理这些工作负载所需的硬件技术方面具有非常大的优势,尤其是英伟达推出的A100/H100 GPU芯片极度适合AI训练和运行机器学习软件,这也是支持Open AI旗下火爆全球的ChatGPT的最关键底层硬件。

AMD首席执行官苏姿丰(Lisa Su)在发布会上表示:“我们仍处于人工智能生命周期的非常非常早期的阶段。”“毫无疑问,在可预见的未来,人工智能将成为硅消费的关键驱动力。”

苏姿丰在发布会中预测,到2027年,数据中心人工智能加速器(AI accelerators )的潜在市场总额预计将增长五倍,达到1500亿美元以上。

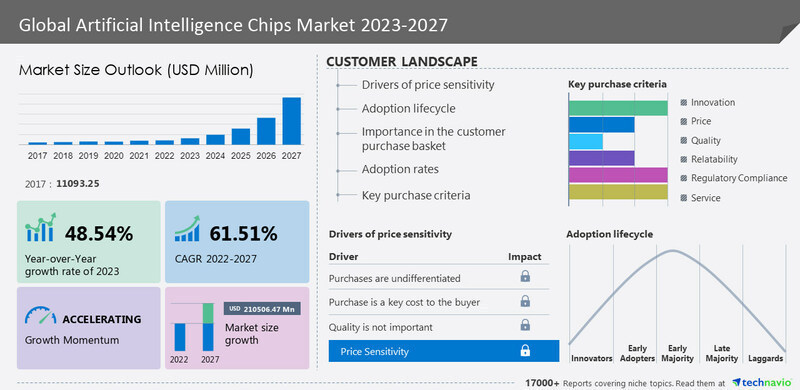

市场调研机构Technavio 此前公布的一份最新研报显示,范围涵盖GPU、CPU、FPGA、ASIC的人工智能 (AI) 用途芯片市场规模预计在2022-2027年期间以高达惊人的61.51%的复合年增长率爆炸式增长,在2027年达到大约2105亿美元的市场规模。

Technavio表示,市场规模扩张取决于几个因素,其中包括数据中心越来越多地采用人工智能芯片,企业越来越多地关注智能手机的人工智能芯片开发,以及自动驾驶汽车中人工智能芯片的开发。

投资者们似乎反应冷淡,发布会未能促进AMD股价继续上行

尽管如此,这场关于AI芯片的演讲并没有让投资者眼花缭乱,他们此前已经对人工智能市场规模的扩张速度抱有极高的期望。截至周一收盘,AMD股价今年累计上涨接近95%,但在周二的发布会结束后,截至周二美股收盘,AMD股价跌幅超过3%,其竞争对手英伟达股价反而涨近4%。今年迄今为止,AMD竞争对手英伟达的涨幅则高达惊人的186%。

值得注意的是,英伟达的市场领先地位不仅来自其芯片硬件产品,还来自十多年来为人工智能领域的研究人员提供各种软件工具,并成功预测在需要数年时间设计的芯片中需要什么软件以及哪些类型的软件,并且构成了完整的“英伟达AI硬件+软件生态系统”。

AMD周二更新了其Rocm软件,该软件与英伟达的Cuda软件平台竞争。AMD总裁表示,在构建强大的软件堆栈方面,AMD取得巨大进步,ROCm软件栈可与模型、库、框架和工具的开放生态系统配合使用。

来自研究机构Moor Insights & Strategy的分析师Anshel Sag表示:“即使AMD在硬件性能方面具有绝对的竞争力,但人们似乎仍不相信AMD的软件解决方案生态环境能与英伟达相媲美。”

AMD新品已获科技巨头亚马逊和Meta青睐

据了解,美国科技巨头亚马逊(AMZN.US)旗下AWS和Facebook母公司Meta Platforms(META.US)的高管与苏姿丰在台上讨论了在他们的数据中心使用全新的AMD处理器。这家芯片巨头还宣布,其最新版本的Epyc服务器处理器和一款名为Bergamo的新变体版本已经全面上市,该全新版本旨在用于云计算。

AMD表示,已开始向Meta等公司大量出货一款名为Bergamo的通用中央处理器芯片。Facebook母公司Meta负责计算基础设施的Alexis Black Bjorlin表示,该公司采用了Bergamo芯片,该芯片针对的是AMD数据中心业务的另一部分,该业务主要面向云计算提供商和其他大型芯片买家。

帮助创建人工智能开源软件的Meta副总裁Soumith Chintala表示,他与AMD密切合作,使得人工智能开发人员更容易使用更加自由的工具,从人工智能芯片的“单一主导供应商”转换到AMD提供的其他产品。Chintala在会上表示:“你实际上不必做很多工作——或者在很多情境下毫不费力,但是能够实现从一个平台到另一个平台。”

此外,随着第四代EPYC处理器AMD Genoa-X的推出,另一科技巨头微软(MSFT.US)表示,其Azure云平台正在为芯片提供新的Hbv4和HX云实例,用于技术层面的计算。

AMD表示,MI300X加速器基于AMD的CDNA 3技术,使用高达192GB的内存来处理大语言模型和生成式人工智能的工作负载。AMD强调,主要客户将在第三季开始试用该技术,第四季开始有望实现全面生产。另一个型号,Instinct MI300A,现在正在向客户推出。苏姿丰演示中介绍,AMD的Instinct MI300A号称全球首款针对AI和高性能计算(HPC)的加速处理器(APU)加速器。在13个小芯片中遍布1460亿个晶体管。

扫码下载智通APP

扫码下载智通APP